Notre service SEO

Audit SEO

Réalisez un audit SEO,

100% adapté à votre site web,

avec un regard extérieur expert.

Analyse complète et sur-mesure

Recommandations détaillées et actionnables

Audit réalisé par un expert SEO senior

Méthode inspirée par Olivier Andrieu

Audit SEO : la définition d'Abondance

L'audit de référencement naturel est une analyse complète et détaillée des différents éléments qui sont susceptibles d'affecter la visibilité et le positionnement d'un site sur les moteurs de recherche (Google, Bing, etc). Cet examen approfondi sert à identifier les forces et les faiblesses de votre site web en termes de référencement. Son objectif est de fournir des préconisations afin d'améliorer l'optimisation des pages du site pour les moteurs de recherche et donc, leur classement dans les résultats.

Chez Abondance, nous examinons de nombreux aspects lors de notre analyse SEO : la structure du site, son contenu, les balises méta, l'utilisation de mots-clés pertinents, les liens entrants et sortants, le temps de chargement des pages, etc. L'audit inclut aussi un audit concurrentiel pour déterminer comment votre site se compare aux sites concurrents.

L'audit est une étape cruciale pour comprendre ce qui fonctionne bien sur votre site, ce qui peut être optimisé et la façon dont vous pouvez passer devant vos concurrents dans les SERP.

Quand faire un audit SEO de votre site web ?

Certains moments sont plus propices que d'autres pour analyser son site et élaborer une stratégie de référencement naturel. Quels sont les cas où il est utile de faire un audit SEO de votre site ?

Vous voulez savoir où vous en êtes.

Un audit réalisé 1 fois par an ou tous les 2 ans vous assure qu’il fonctionne bien et vous permet de savoir exactement sur quels points travailler pour l’améliorer. Ces données vous aideront à améliorer votre stratégie SEO.

Vous avez subi une baisse de trafic.

Vous ne savez pas pourquoi votre visibilité a baissé et vous aimeriez comprendre les causes de cette chute de positions. Elles peuvent être nombreuses : concurrence féroce, erreurs techniques sur votre site, faible popularité, contenus non adaptés...

Malgré vos efforts, votre site ne se positionne pas.

Vous avez l’impression d’avoir “tout bien fait”, mais les résultats ne sont pas là. Un audit vous aide à y voir plus clair et à savoir ce qui ne plaît pas aux moteurs de recherche, en particulier Google. Vous saurez exactement sur quels points travailler, étape par étape.

Vous allez faire une refonte.

Vous allez bientôt refondre votre site ou le migrer, et vous souhaitez savoir ce qu’il faut garder ou corriger dans la prochaine version. Nom de domaine, URL, pages, maillage interne, netlinking : l'analyse sera effectuée sous le prisme de la refonte.

Pourquoi faire un audit SEO ?

Un bon audit SEO est le point de départ de toute stratégie digitale visant à développer la visibilité d'un site internet. C'est lui qui vous guidera dans les grandes décisions à prendre, à travers une priorisation des tâches, dans l'atteinte de vos objectifs commerciaux.

État des lieux précis

Vous saurez exactement où en est votre site web à l’instant T. Nous récupérons toutes les données importantes de votre site pour en extraire des recommandations qui amélioreront sa santé et son positionnement.

Actionnable immédiatement

La force de notre audit SEO, c’est qu’il est 100% concret, avec des actions priorisées selon leur importance et leur difficulté. Nous vous proposons des actions à mettre en place sur le long terme, comme des quick wins qui auront un effet rapide sur votre site.

Création d'une nouvelle stratégie

Grâce à notre état des lieux et sa livraison dans un rapport Notion simple à prendre en main, vous pourrez développer une nouvelle stratégie SEO à partir de nos constats et de nos recommandations. Toute l’analyse est faite, il ne vous reste plus qu’à implémenter !

Amélioration de l'expérience utilisateur

Nos recommandations incluent souvent des améliorations de l'expérience utilisateur, telles que des temps de chargement plus rapides, une navigation intuitive et un design convivial. Cela peut inciter les internautes à rester plus longtemps sur votre site.

Vous souhaitez réaliser

un audit SEO de votre site web ?

L'audit SEO de votre site est réalisé sur-mesure par un expert Abondance, sous un délai de 1 mois. Suite à l'audit, un rapport complet avec des recommandations concrètes vous est livré et une restitution orale est organisée.

Que contient un audit SEO complet ?

Audit SEO technique

L'audit technique SEO est extrêmement important, car des problèmes techniques sur votre site peuvent empêcher la bonne interprétation du site par les moteurs de recherche, affecter l’expérience utilisateur et compromettre vos résultats en SEO. Nous analysons votre code HTML, votre fichier robots.txt, votre sitemap, vos redirections, la webperformance, la vitesse de chargement, la sécurité, la compatibilité mobile, etc.

Audit sémantique

Vos contenus doivent être pertinents, utiles et originaux. Si certaines de vos pages possèdent des contenus pauvres, mieux vaut les supprimer ou les optimiser. Durant l’audit sémantique de votre site, nous faisons un état des lieux de votre positionnement et déterminons les mots-clés les plus intéressants à travailler. Nous vérifions les pages à optimiser, les images, le balisage Hn, les titles, les méta-descriptions, les liens internes, l’arborescence, le contenu dupliqué, etc.

Audit netlinking

La popularité et la réputation d’un site se mesure par les liens externes qui pointent vers lui. Dans notre audit de netlinking, nous analysons ainsi le nombre de backlinks, leur qualité, les pages cibles, les ancres de liens et vous proposons des stratégies de netlinking à déployer. Nous regardons aussi comment votre site se positionne par rapport à vos principaux concurrents.

Les bénéfices long-terme de l'audit SEO

Une fois votre audit réalisé, vous allez mettre en place des actions, certaines rapides et d'autres plus compliquées à implémenter. Sur le long-terme, vous récolterez les fruits des recommandations de notre audit SEO.

Trafic qualifié

Les utilisateurs qui trouvent votre site grâce à la recherche organique sont souvent plus qualifiés, car ils recherchent activement des informations, des produits ou des services liés à ce que vous proposez. Cela signifie que le trafic provenant du SEO a plus de chances de se convertir en clients ou en leads.

Rentabilité à long terme

Comparé à d'autres canaux de marketing tels que la publicité payante, le SEO peut offrir un excellent retour sur investissement à long terme. Une fois que vous avez effectué les optimisations nécessaires, vous pouvez continuer à bénéficier d'un trafic accru sans avoir à payer pour chaque clic.

Confiance et crédibilité

Les utilisateurs ont tendance à faire davantage confiance aux résultats organiques des moteurs de recherche par rapport aux annonces payantes. Un classement élevé dans les résultats de recherche peut renforcer la crédibilité de votre marque et la confiance des utilisateurs.

Conversions facilitées

Une fois positionné sur les bonnes requêtes commerciales et transactionnelles, grâce au travail réalisé sur vos mots-clés et vos contenus, vous boosterez vos conversions et votre chiffre d’affaires. Les internautes cherchant à acheter un produit ou un service cliqueront sur votre site, grâce à vos efforts SEO.

Quel est le prix d'un audit SEO ?

Pour vous donner un ordre d’idée, l'audit SEO d'un site web “classique” est facturé la plupart du temps aux alentours de 2 500 euros HT. Un investissement susceptible d’augmenter en fonction des spécificités du site ou de vos demandes. Un audit SEO bien fait n'est pas un coût mais un investissement durable. Chez Abondance, chaque projet est unique et chaque audit SEO est sur-mesure. Il est donc difficile de donner une réponse toute faite ! Le prix de votre audit SEO va varier en fonction de plusieurs facteurs :

- La taille du site web : l'investissement ne sera pas le même si vous avez un site de 10 ou de 10 000 pages. Plus le nombre de pages est élevé, plus le temps de l’audit est important.

- Le type de site web : un site vitrine simple sera plus facile à analyser qu’un site e-commerce ou qu’un site multilingue. Nous prenons également en compte votre présence sur Discover ou Google Actualités.

- Les éléments de l’audit : un audit complet vous fournit des informations sur la technique, la sémantique et la popularité de votre site. Le prix peut varier en fonction de l’exhaustivité de l’audit. Un audit de surface sera certes moins cher qu’un audit complet, mais sûrement moins actionnable.

- L’expérience du prestataire : en toute logique, une agence expérimentée facturera son audit plus cher qu’un débutant ou un freelance. Mais faire appel à un prestataire senior vous permet de bénéficier de ses connaissances et de son expérience. Chez Abondance, nos experts SEO ont tous plus de 10 ans d’expérience.

Vous souhaitez connaître le prix de l'audit SEO de votre site ?

En utilisant notre simulateur de prix, vous obtiendrez en moins de 5 minutes une estimation du coût de votre audit SEO, réalisé par les experts Abondance. Il vous suffit simplement d'entrer quelques informations concernant votre site, indispensables pour calculer le prix moyen de votre audit.

Réalisez (enfin) un audit au service

de votre positionnement SEO

L'objectif de nos audits SEO : une stratégie complète pour vous permettre de passer à l'action et de gagner en visibilité sur les moteurs de recherche !

Neutralité

Un œil extérieur est nécessaire pour ce type d’analyse. Nous vous communiquons simplement les actions à mettre en œuvre, sans vous vendre de prestations à la suite de l’audit de référencement naturel.

Expertise

Abondance a plus de 25 ans d’existence et nos experts ont tous une dizaine d’années d’expérience. Nos compétences nous permettent d’analyser un grand nombre de sites, qu’ils aient 10 ou 10 000 pages.

Sur-mesure

L'audit est adapté à vos problématiques. Le rapport pondère et met en avant les éléments prioritaires à optimiser pour répondre à vos objectifs et au contexte de votre site.

Activation

A la suite de notre travail, nous vous délivrons un rapport Notion simple à prendre en main contenant nos recommandations concrètes, classées par ordre de priorité, ainsi qu’une restitution orale.

Vous avez un projet d'audit SEO pour votre site web ?

Organisons un rendez-vous (gratuit) dès maintenant pour échanger sur vos besoins et estimer le prix de votre audit ! Thibaud, expert SEO Abondance, se tient à votre disposition pour répondre à vos questions et vous proposer une offre d'audit sur mesure.

La méthode d'audit SEO par Abondance

Que votre site vienne tout juste d'être lancé ou qu'il ait déjà plusieurs années, qu'il contienne quelques pages ou des milliers, nous avons mis en place une méthodologie efficace et éprouvée qui répond à chaque besoin.

Prise de brief

Une fois l’audit signé, nous prenons rendez-vous ensemble pour vous poser quelques questions, afin d’en savoir plus sur votre site, vos besoins et vos priorités business.

Analyse

En fonction de notre planning, le délai de réalisation s’étend de 1 à 4 semaines, en général. Nous analysons la technique, le contenu et la popularité de votre site internet.

Rapport Notion

Nous vous livrons un rapport Notion clé en main avec le détail de nos analyses, le niveau de difficulté des actions et leur priorité, ainsi qu’une synthèse de l’audit.

Restitution orale

Nous convenons ensemble d’un rendez-vous afin de vous expliquer les résultats de votre audit SEO et nos recommandations, et répondre à vos éventuelles questions.

Les outils SEO utilisés pour nos audits

Faire un audit SEO avec Abondance, c'est la garantie d'utiliser les meilleurs outils disponibles sur le marché. Couplé à notre expérience et notre expertise d'analyse, nous vous fournirons toutes les recommandations nécessaires pour améliorer votre site.

Screaming Frog et OnCrawl nous permettent de crawler votre site et de déceler les erreurs techniques qui ont un impact sur votre positionnement. Avec Yourtext.guru et Semrush, nous sommes en mesure de vous faire des recommandations éditoriales. Enfin, nous vérifions le nombre et la qualité de vos backlinks grâce à SEObserver. Ces outils SEO payants nous permettent de récupérer le maximum de données sur votre site et d’en faire des analyses poussées pour vous offrir un plan d’actions 100% adapté à vos besoins.

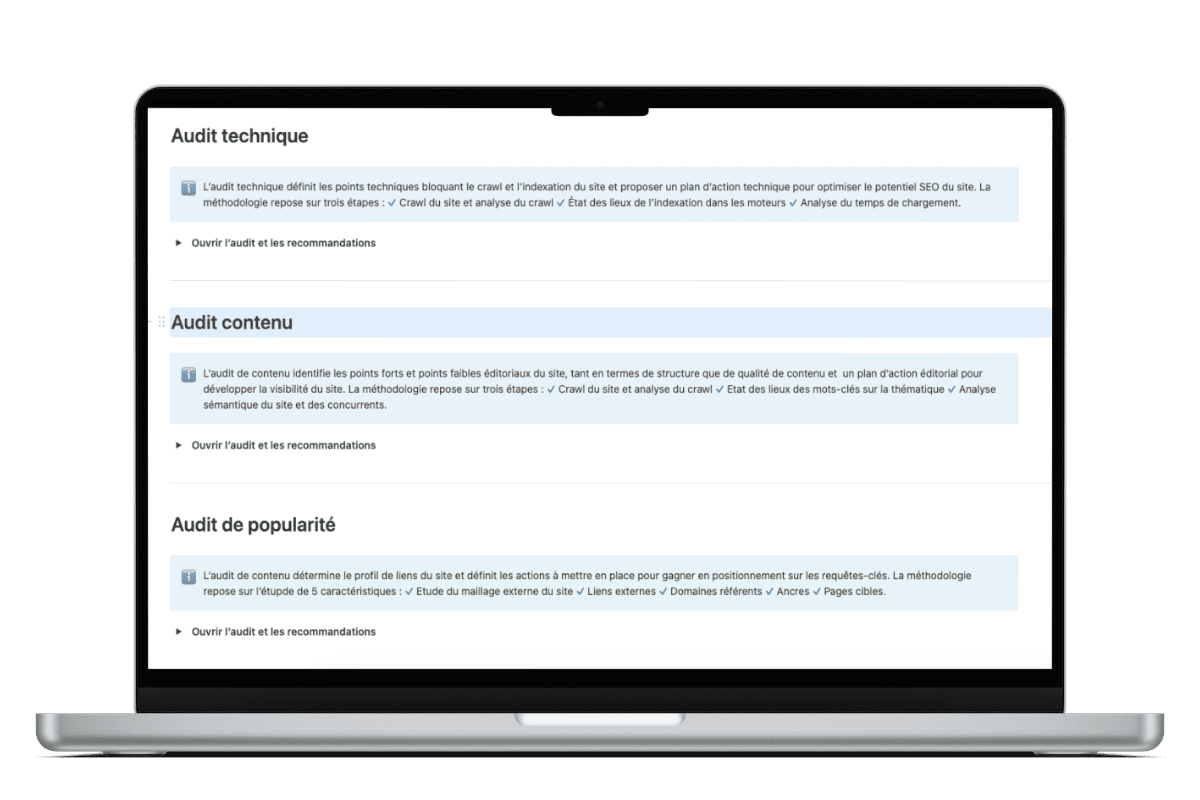

Exemple de la méthodologie Abondance pour un audit SEO

Contenu de l'audit

Un rapport de l'audit

L'audit technique

L'audit contenu

L'audit de netlinking

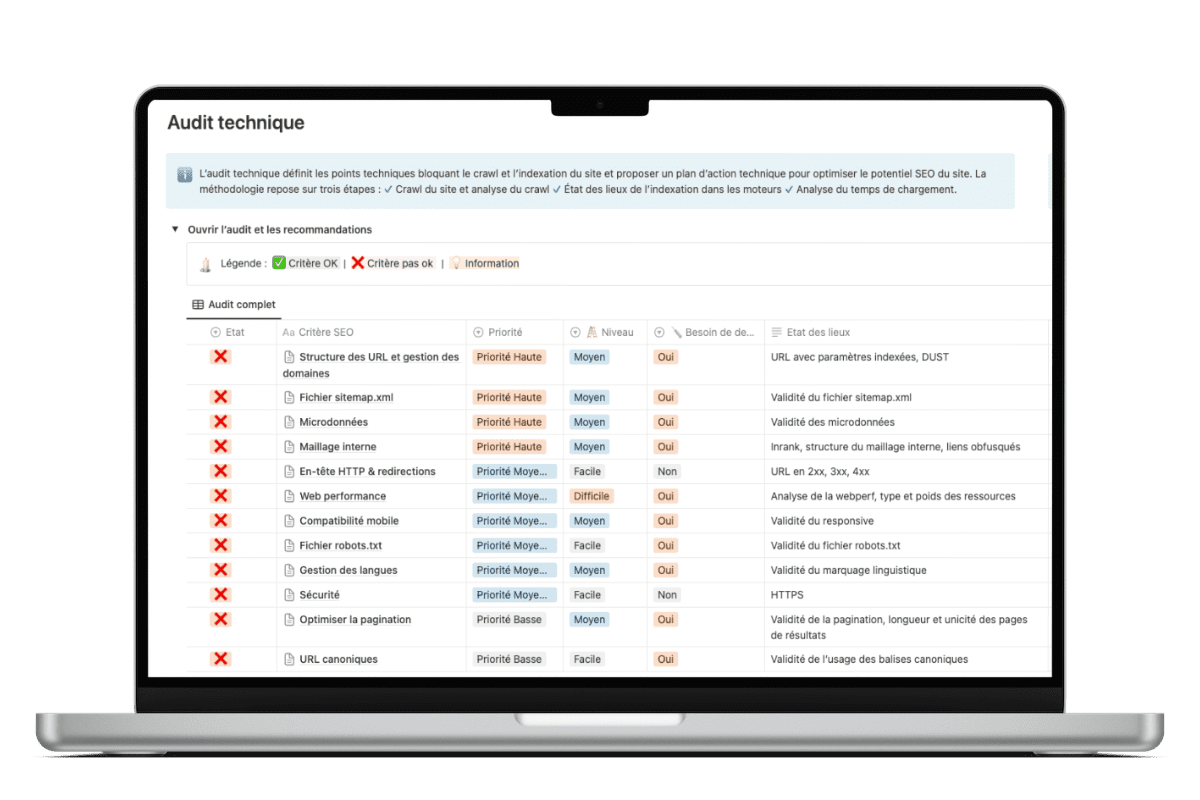

Format de l'audit

Pour chaque partie de l'audit, un tableau reprenant l'ensemble des critères SEO, accompagnés de la priorité de traitement, le niveau de difficulté et l'état des lieux

Pour chaque critère SEO, notre analyse, nos recommandations, des annexes et des ressources utiles

Découvrez aussi notre audit SEO flash !

Alternative à notre audit SEO complet, l'audit flash SEO vous permet d'obtenir rapidement les principaux points d'amélioration de votre site.

Des questions sur l'audit SEO ? Nos experts vous répondent.

-

L'audit SEO d'Abondance est-il manuel ou automatique ?

Tous nos audits sont réalisés manuellement, ils ne sont en rien le fruit d'une quelconque automatisation. Si une méthodologie de départ est bien entendu respectée, le contenu est ensuite rédigé par un expert Abondance et non pas par des logiciels, en fonction de l'analyse de votre site web. Il s'agit là, selon nous, de la seule façon de vous proposer un travail qui réponde le plus parfaitement possible à vos attentes et besoins.

Nous utilisons bien sûr des outils permettant d'obtenir des données précises de façon macroscopique (Search Console, crawl, Analytics, analyse du maillage interne), mais toutes nos conclusions sont basées sur notre réflexion et notre expérience.

-

Quelles sont les conditions de paiement et de livraison de l'audit ?

Les conditions de paiement sont les suivantes : 50% à la commande, 50% une fois l'audit réalisé.

Voici nos délais de réalisation : la mise à l'agenda de l'audit démarre une fois l'acompte de 50% versé. En règle générale, il est envoyé de 1 à 4 semaines après, en fonction de la charge de notre calendrier.

-

Proposez-vous des audits SEO gratuits ?

Non, tous nos audits sont payants car ce ne sont pas des pré-audits ou des audits de surface. Nos audits sont exhaustifs et couvrent les 3 piliers du SEO : la technique, le contenu et la popularité. Nos recommandations suffisent pour vous fournir une base de travail complète, sur plusieurs mois voire un an.

-

Quels outils utilisez-vous pour réaliser l’audit ?

Dans le cadre de nos audits, nous sommes amenés à utiliser les outils suivants :

- Google Search Console

- Google Analytics

- Oncrawl

- Semrush

- SEObserver

- Cocon.se

- Screaming Frog

- Tout autre outil qui nous apparaît important pour vos besoins spécifiques

>> Découvrez notre liste des meilleurs outils pour un audit SEO.

-

Faut-il être un expert pour comprendre le contenu de l'audit SEO ?

Toutes les notions touchant au référencement et à l'optimisation de site web pour le référencement sont expliquées dans le contenu de l'audit, il n'est donc pas nécessaire d'être un expert SEO pour comprendre les informations fournies.

En revanche, une connaissance, même de base, du langage HTML sera utile pour appréhender de façon complète et efficace les différentes informations fournies. Mais rien de très technique cependant… Un premier vernis SEO suffit pour tout comprendre.

-

Quelles sont les étapes suite à la réalisation de l'audit ?

Une fois que nous avons terminé l'analyse de votre site internet, vous recevez notre rapport Notion avec nos recommandations classées par ordre de priorité. Cet ordre se base sur la gravité des erreurs ou problèmes rencontrés et sur les efforts requis pour les résoudre. Nous vous précisons toujours si vous aurez besoin d'un développeur ou non pour chaque recommandation. L'audit fourni peut vous servir de roadmap annuelle : positionnez les différentes actions à entreprendre sur l'année, en fonction de vos ressources. Stratégie de content marketing, netlinking, résolution d'erreurs techniques... c'est à vous d'établir votre stratégie d'après nos conseils.

-

De quels éléments avez-vous besoin pour commencer l'audit SEO ?

Nous avons besoin :

- D'un accès à votre site : version en ligne ou en développement (vous devrez nous fournir les éléments de connexion dans ce cas) ;

- D'un accès à votre compte Google Search Console. Un document décrivant la procédure à suivre vous sera fourni ;

- Si possible d'un accès à votre outil de mesure d'audience (Google Analytics, Matomo, etc.). Un document décrivant la procédure à suivre vous sera fourni.

A priori, cela suffit, sauf demande spécifique de votre part.

-

Proposez-vous un accompagnement SEO à l'année ?

Non, nous ne proposons pas de formule ou d'offre de référencement sur l'année (suivi de positionnement, acquisition de backlinks, etc.). Nous proposons uniquement la réalisation d'un audit SEO, qui vise à analyser les principaux critères SEO, repérer les points critiques et vous livrer des recommandations pour les corriger. Nous ne proposons pas d'offre de suivi de mise en place de ces recommandations ou d'accompagnement SEO en fil rouge. En revanche, nous pouvons vous mettre en relation avec des experts SEO partenaires d'Abondance. Pour en savoir plus à ce sujet, contactez-nous.

-

Est-ce vous qui mettez en place les préconisations de l'audit SEO ?

Non, l'audit SEO contient une feuille de route qui liste les actions à mettre en place de façon claire et précise. Ce sont ensuite vos équipes en interne ou l’agence qui vous accompagne qui mettront en place ces recommandations.

Le rapport Notion remis contient toutes les informations dont elles auront besoin, mais elles pourront toujours nous contacter si elles ont des questions.

Si besoin, nous pouvons vous mettre en relation avec nos partenaires Abondance qui se feront un plaisir de mettre en oeuvre nos préconisations. Contactez-nous !

-

Mon prestataire SEO peut-il faire l'audit lui-même ?

Un œil extérieur est toujours intéressant, voire nécessaire, pour apporter un regard neuf sur les éléments SEO de votre site web et identifier les potentiels correctifs à mettre en place 🙂

-

Comment faire un audit SEO soi-même ?

S'il est possible de faire soi-même son audit SEO, ce n'est pas forcément judicieux car de véritables compétences en matière de référencement naturel sont nécessaires pour que votre audit soit efficace. De plus, un regard externe est toujours intéressant ! Voici tout de même les principaux éléments à analyser lors d'un audit :

- la présence d'erreurs 404

- la présence de redirections 301 / 302

- l'indexation de vos pages

- la présence d'un sitemap

- la structure de votre site web et son maillage interne

- la vitesse de votre site

- son adaptation au mobile

- l'optimisation de vos contenus (balise title, balises Hn, attribut alt, longueur...)

- la présence de contenu dupliqué

- le nombre et la pertinence de vos backlinks...

Vous souhaitez nous confier l'audit SEO de votre site web ?

Échangez dès maintenant avec Thibaud, expert SEO chez Abondance, sur vos besoins et obtenez une offre d'audit sur mesure ! Pour cela, rien de plus simple, il vous suffit de planifier un rendez-vous téléphonique directement en ligne.